Los microformatos son básicamente pequeños fragmentos de HTML, normalmente utilizados para publicación en diferentes sitios, como los blogs, comentarios, eventos, etc. Se considera como un signo positivo para el SEO , ya que se muestra en los resultados de búsqueda (SERP). Por ejemplo, la especificación HTML5 nos describe los microformatos como una manera de etiquetar contenido para describir un tipo específico de información, por ejemplo, las revisiones, la información persona, o eventos. Cada tipo de información describe un tipo específico de elemento, como una persona, y el evento, o una revisión. Por ejemplo, un evento tiene la sede propiedades , hora de inicio , el nombre y categoría. En esta entrada se argumenta si realmente mejoran el Seo y de que manera. Leer más…

{lang: 'es'}

martes, 10 de abril de 2012

jcamweb

En un blog dedicado a la optimización de webs para la indexación por buscadores, seo, lo corriente es esperar artículos que describan técnicas para en cada paso del proceso de crear una web, mejorar el valor que dan los motores de búsqueda a nuestras páginas para el tema que tratan. Pero una vez que se tiene un conocimiento medio del más amplio tema del marketing en internet, que por un lado los motores de búsqueda son scripts que visitan nuestras páginas y cuales son los puntos que estos scripts hacen valorar más o menos nuestras páginas, algunos usuarios pueden querer más allá abusando del conocimientos de estos puntos y querer engañar a los buscadores saturando con las técnicas de optimización. Lo primero, ténicas naturales, es lo que se conoce como «white hat» seo, lo segundo «black hat» seo. Un sinónimo de este segundo término es search spam, y estos métodos son usados por compañías que garatizan una posición concreta en un plazo de tiempo corto. Este debe ser el punto cero para evitar que se use «black hat» seo en nuestra web, no contratar con quienes nos garantize una posición concreta a corto plazo, ya que el posicionamiento natural depende tanto de factores internos y externos, estos últimos no controlables. En cuanto a las otras 5 técnicas las describimos a continuación. Leer más…

En un blog dedicado a la optimización de webs para la indexación por buscadores, seo, lo corriente es esperar artículos que describan técnicas para en cada paso del proceso de crear una web, mejorar el valor que dan los motores de búsqueda a nuestras páginas para el tema que tratan. Pero una vez que se tiene un conocimiento medio del más amplio tema del marketing en internet, que por un lado los motores de búsqueda son scripts que visitan nuestras páginas y cuales son los puntos que estos scripts hacen valorar más o menos nuestras páginas, algunos usuarios pueden querer más allá abusando del conocimientos de estos puntos y querer engañar a los buscadores saturando con las técnicas de optimización. Lo primero, ténicas naturales, es lo que se conoce como «white hat» seo, lo segundo «black hat» seo. Un sinónimo de este segundo término es search spam, y estos métodos son usados por compañías que garatizan una posición concreta en un plazo de tiempo corto. Este debe ser el punto cero para evitar que se use «black hat» seo en nuestra web, no contratar con quienes nos garantize una posición concreta a corto plazo, ya que el posicionamiento natural depende tanto de factores internos y externos, estos últimos no controlables. En cuanto a las otras 5 técnicas las describimos a continuación. Leer más…

{lang: 'es'}

lunes, 17 de octubre de 2011

jcamweb

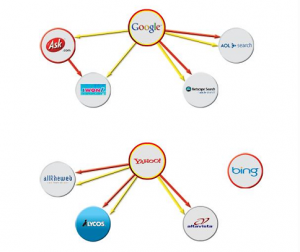

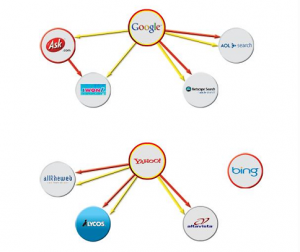

Hace algunos años ya desde que se pensó en internet como una red de recursos distribuida. Entonces te bastaba una simple lista de pares host/ip donde podías tener qué recursos tenía que servidor. Pero a medida que fue aumentando la información estos «directorios» escritos a mano se hacían difíciles de manejar, apareciendo alternativas a catalogar y acceder a la información como el protocolo gopher, un sistema jerarquizado de documentos que permitía organizar la información. Pero no fue hasta que se impuso la www y Jerry Yang y David Filo decidieron renombrar su directorio «guía para la World Wide Web» como yahoo que puede hablarse de un primer buscador tal como lo entendemos ahora.

Hace algunos años ya desde que se pensó en internet como una red de recursos distribuida. Entonces te bastaba una simple lista de pares host/ip donde podías tener qué recursos tenía que servidor. Pero a medida que fue aumentando la información estos «directorios» escritos a mano se hacían difíciles de manejar, apareciendo alternativas a catalogar y acceder a la información como el protocolo gopher, un sistema jerarquizado de documentos que permitía organizar la información. Pero no fue hasta que se impuso la www y Jerry Yang y David Filo decidieron renombrar su directorio «guía para la World Wide Web» como yahoo que puede hablarse de un primer buscador tal como lo entendemos ahora.

A partir de aquí la historia es más conocida y nombres como ole, ozu y google, bing, baidu, yandex, más estos últimos, es lo primero que tecleamos en el navegador cuando queremos consultar información. Pero no son los únicos, sino que hay un extenso número de buscadores, menos conocidos que no proporcionan ellos sus resultados de búsqueda, sino que se «alimentan» de los más conocidos. Veamos un poco esta jerarquía de dependencias y así evitarnos querer que nuestras páginas sean indexadas por buscadores que realmente no crean índices propios. Leer más…

{lang: 'es'}

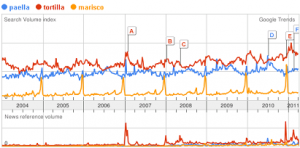

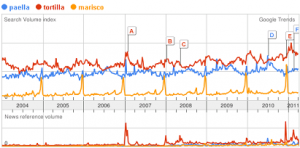

En cualquier estudio de marketing hay una fase de muestreo, bien previa a un nuevo lanzamiento, posterior para seguimiento de la campaña. El principio del estudio estadístico es conseguir una muestra suficiéntemente significativa del mercado objetivo, diseñar una serie de test, contratar personal que haga las encuestas, y claro analizar los resultados para mostrar que tal se comporta nuestra campaña para los objetivos marcados. Todo esto lleva un gasto de recursos humanos, tiempo y dinero, pero ¿qué pasaría si ya tuviéramos una muestra de millones de usuarios?, repartida a lo largo de los 5 continentes y un partner como google que ya se ha preocupado de crear unas estupendas gráficas con lo que los usuarios buscamos en su portal a lo largo del tiempo. Pues bien esto son google trends y google insights veamos ahora cómo podemos usarlos. Leer más…

En cualquier estudio de marketing hay una fase de muestreo, bien previa a un nuevo lanzamiento, posterior para seguimiento de la campaña. El principio del estudio estadístico es conseguir una muestra suficiéntemente significativa del mercado objetivo, diseñar una serie de test, contratar personal que haga las encuestas, y claro analizar los resultados para mostrar que tal se comporta nuestra campaña para los objetivos marcados. Todo esto lleva un gasto de recursos humanos, tiempo y dinero, pero ¿qué pasaría si ya tuviéramos una muestra de millones de usuarios?, repartida a lo largo de los 5 continentes y un partner como google que ya se ha preocupado de crear unas estupendas gráficas con lo que los usuarios buscamos en su portal a lo largo del tiempo. Pues bien esto son google trends y google insights veamos ahora cómo podemos usarlos. Leer más…

{lang: 'es'}

miércoles, 1 de diciembre de 2010

jcamweb

En la entrada Quiero un portal web 2.0, ya se escribieron unas breves líneas sobre que entendía por una web 2.0, un portal en el que los usuarios son la principal fuente de los contenidos, aumentando la interactividad, compartir contenidos con otros usuarios y teniendo como resultado una afiliación entre usuarios/portal. Añado la relación de las diferencias entre web 1.0 y web 2.0 según Tim O’Reilly. Además de esta comparativa entre tipos de webs, se hablan de una serie de tecnologías que destacan en la web 2.0, serían interfaces ricas, ria, facilidad de sindicación, rss, o el uso de mashup.

Y entonces ¿la web 3.0?, aunque se mencionan distintos conceptos, desde una web 3d a una presente en todo tipo de dispositivos, el que más se asocia a la web 3.0 es el de web semántica. Como he escrito sobre la web 2.0 se tiene una web alrededor de los contenidos aportados por el usuario, con posibilidades a través de tags en estos contenidos para que unos usuarios compartan estos contenidos. Pero estos documentos/contenidos que crean los usuarios tienen aún un bajo nivel de descripción sobre ellos mismos, metatags, lo que hace necesario por otra parte pasar bastante tiempo delante de buscadores/indexadores cuando queremos algo concreto. En la web 3.0, si quiere añadir estándares descriptivos, semánticos, de manera que por un lado los propios servicios que alojan la información sean capaces de ordenar mejor esta información, pero por otro lado los usuarios podamos interactuar con esta información sin tener que conocer algún lenguaje de consulta artificial.

En cuanto a estándares tecnológicos que estarían en la web 3.0, podemos mencionar RDF (Resource Description Framework), lo que permitiría una mejor descripción de los documentos y xml (eXtensible Markup Language) que permitiría el intercambio de información entre los sistemas que alojan los documentos.

{lang: 'es'}